当《开心消消乐》遇上 AI 推理,我们找到了高质量关卡背后的原因!

随着 AI 热潮席卷各行各业,其落地应用已经成为企业技术研发升级的工作重心。人工智能应用的升级不仅需要软件层面的升级迭代,还需要大规模基础设施的支撑。然而,自行搭建大规模算力、存储基础设施对于大多数企业而言都存在技术难度、人力资源、成本投入等多方面的挑战。因此,企业在探索 AI 实践时往往更倾向于选择云服务,尤其是云计算大厂提供的成熟云端计算实例来部署 AI 模型和服务,而在具体落地过程中,不同行业存在的痛点各异,对云基础设施的需求也有所不同。

好玩有趣的关卡背后,创新 AI 模型的突破与挑战

由于游戏行业的需求复杂,其相对较晚受到 AI 创新浪潮的影响,独特的创新周期、对游戏性和故事性的高要求,以及市场接受度和玩家期望的多样性,也延缓了 AI 在游戏中的广泛应用。再加上对经济因素和开发成本的考量,使得游戏行业在采纳 AI 技术时持谨慎态度。

然而,随着 AI 技术的不断进步和成本的降低,以及市场对高质量游戏体验需求的日益增长,游戏行业正积极地探索和应用 AI 技术来提升游戏品质和玩家体验,更常见的选择是对成熟的模型方案进行微调,以满足自身需求。

在这种场景下,对上层应用出色的推理能力与性价比则显得更为关键。通过基于成熟方案改造的推理模型以及能够输出高效推理性能的基础设施,使游戏开发团队可以迅速获得 AI 创新的收益,为终端用户带来更好的体验。

乐元素是经典休闲消除游戏《开心消消乐》的开发商,《开心消消乐》凭借着简单易上手的游戏原理和激发玩家好胜心的设计,使得玩家能够迅速融入游戏并享受其中。

《开心消消乐》拥有 9 大关卡类型、60 余种障碍设计、8000 多个精心设计的关卡。用户每日都可以进行游戏关卡挑战,因此,关卡的质量对于游戏的收入和用户留存起着至关重要的作用。乐元素的游戏团队不仅要持续推出新关卡和玩法,还要不断调整线上关卡的体验和难度,为玩家带来新鲜的游戏体验。

过去,乐元素团队主要通过人工流程制作关卡,但效率相对较低,导致新关卡的上线流程较长,很难确保难度一致性,又要考虑玩家离线游玩时是否通过特殊方式“作弊”,新玩法和已有关卡阵容的完整兼容问题,相关的设计和验证工作费时费力。

为此,乐元素创新地在关卡设计等流程引入了自研的 AI 推理模型。对于新增和调整的关卡,推理模型通过大量自动打关任务,确保关卡配置无错误,难度符合预期,并快速验证关卡;对于新开发的玩法,AI 也通过大量自动打关任务确保逻辑无错误。

如今,该模型每天平均运行超过 1 亿次打关任务,推理次数超过 30 亿次。通过 AI 创新,乐元素可以大大减轻开发团队设计新关卡和新玩法时的验证测试负担,使团队将精力从枯燥的验证工作中转移到开发任务上,显著提升开发效率,为玩家带来更多新鲜好玩的游戏内容。

然而,随着《开心消消乐》玩家群规模增长和游戏内容更新,乐元素的 AI 推理模型在实践中开始遇到性能、成本和灵活性三大挑战:

性能挑战:

随着游戏用户数量的增加和游戏内容的扩充,推理模型需要处理的关卡数量不断增多,对玩家玩法的模拟也更加复杂,这就意味着运行模型的服务器需要足够的算力来支持模型完成推理任务。

成本挑战:

游戏运营成本随着用户数量和游戏内容的增加而增加,特别是当部署专用的模型服务器时。因此,乐元素亟需寻找更适合推理的算力选项。

灵活性挑战:

面对不断变化的游戏内容和用户需求,特别是不同的模型推理需求,要求游戏服务器具备足够的灵活性支持。

今年,腾讯云推出的新一代 S8 实例,为乐元素提供了高性能、低成本和灵活性的解决方案,满足了其持续发展的诉求。

聚集三大优势,乐元素将 AI 推理加速方案转向 CPU

在以往的解决方案中,大多数游戏行业的 AI 推理场景会更偏向于性能强大的 GPU 作为算力基础设施。但随着近年来芯片短缺情况恶化,GPU 推理方案成本迅速上升,很多企业开始将目光投向了 CPU,并发现了 CPU 方案的一些显著优势:

成本显著降低:打关模型的 AI 推理任务以离线为主,任务运行时间也相对宽松。因此选用基于低成本、易获得的 CPU 进行推理的云实例在运行时间上可以满足乐元素要求,还可以节约日常开发成本。

资源利用率高:除了打关推理模型外,乐元素日常也有很多通用计算任务需求,使用 CPU 来运行推理模型,可以在闲时继续运行其他通用任务,甚至在游戏流量高峰时快速扩展服务器资源池,有效提升了资源利用率,避免造成资源浪费;

易开发、易部署:基于 CPU 的云实例搭配成熟的软件栈,使游戏公司开发团队能够快速部署推理模型,无需复杂的移植和优化工作。在一些需要快速部署新模型的情况下,所需的时间甚至更短。

CPU 突破 AI 推理难关,英特尔® AMX 引擎成为取胜关键

新一代腾讯云实例 S8 基于全新优化虚拟化平台,提供了平衡、稳定的计算、内存和网络资源。其中,标准型实例采用第五代英特尔® 至强® 可扩展处理器,内存采用最新 DDR5,默认网络优化,最高内网收发能力达 4500 万 pps,最高内网带宽可支持 120Gbps。

腾讯云实例 S8 搭载的第五代至强® 可扩展处理器凭借内置加速器实现单核性能提升,相较上一代产品,其整体性能提升 21%,内存速度提升 16%,且与上一代产品的软件和平台兼容,部署新系统时可大大减少测试和验证工作。

乐元素迁移到腾讯云实例 S8 后,单个实例能够处理的游戏数据和用户请求规模更大,平均成本更低,自研 AI 推理模型的效能大幅提升。

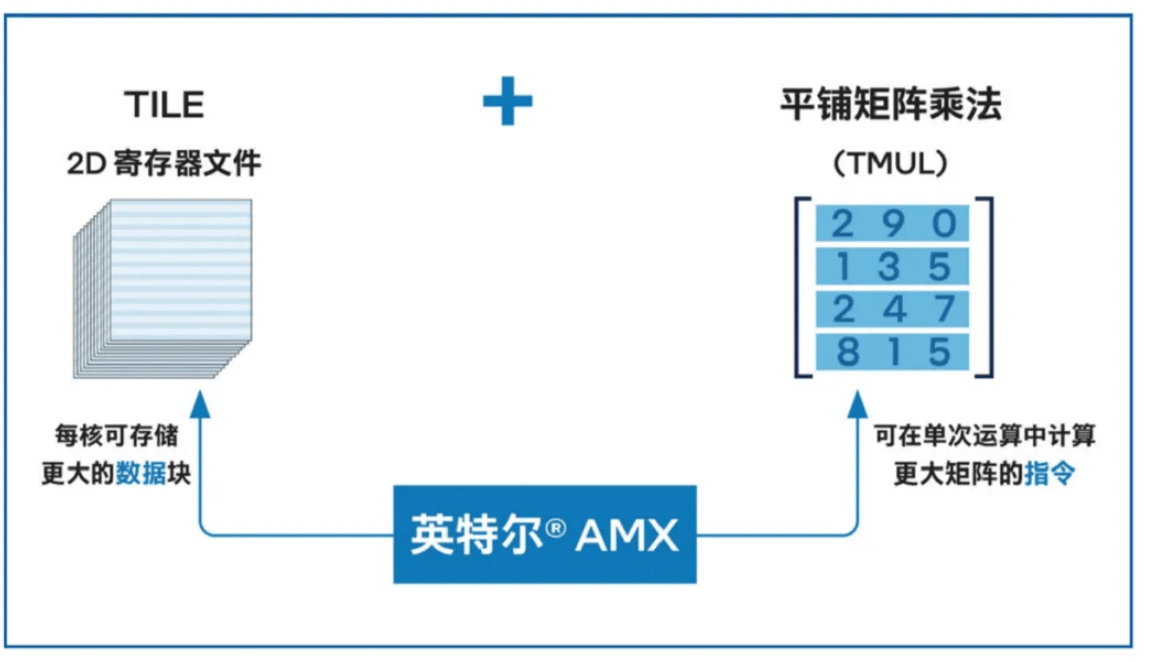

第五代至强® 可扩展处理器内置了英特尔® AMX 加速引擎,可加速基于 CPU 的深度学习推理,避免了使用独立加速器带来的成本和复杂性。英特尔® AMX 引入了一种用于矩阵处理的新框架(包括了两个新的组件,一个二维寄存器文件,其中包含称为 “tile” 的寄存器,以及一组能在这些 tile 上操作的加速器),从而能高效地处理各类 AI 任务所需的大量矩阵乘法运算,提升其在训练和推理时的工作效能。

*英特尔® AMX 架构

通过采用英特尔® AMX 技术,乐元素得以显著提升自研 AI 推理模型的性能,除了提升模型的关卡验证测试效率外,还能满足更多场景的需求。例如英特尔® AMX 技术可以助力快速处理玩家数据,以实现快速的游戏元素调整;快速处理大量数据,创造更加真实和吸引人的在线互动,以提供更加平滑和快速的在线游戏体验。

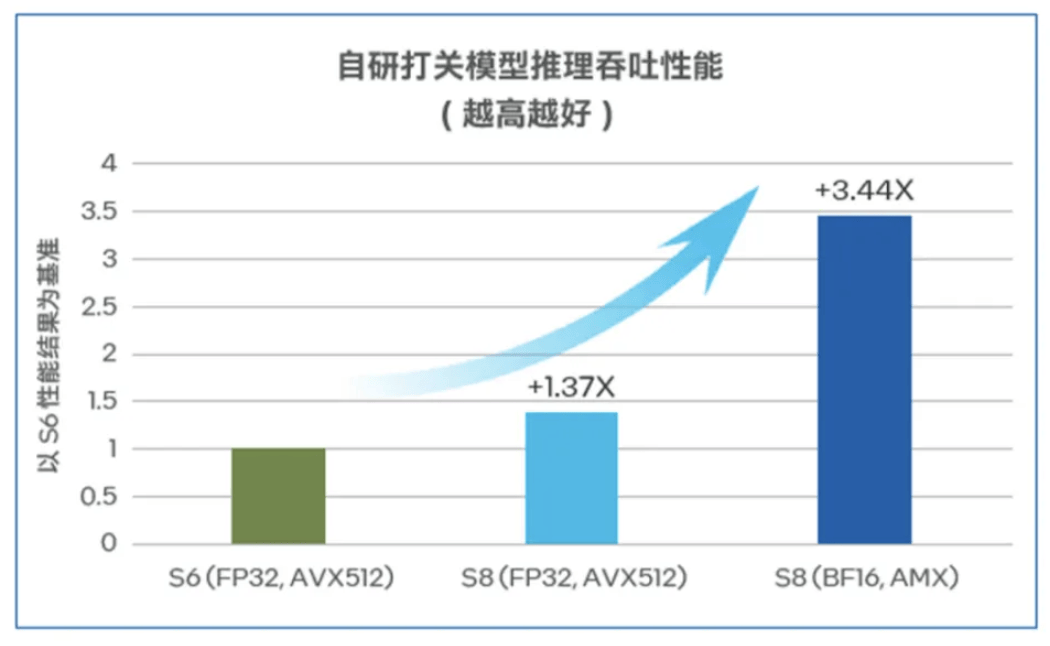

乐元素还对新一代腾讯云 S8 实例进行了性能测试,验证了其代际性能提升。在 AI 打关推理模型的测试中,对比腾讯云与英特尔联合定制优化的第三代至强® 可扩展处理器,启用了英特尔® AMX 技术将模型从 FP32 转化为 BF16 后,第五代至强® 可扩展处理器的推理性能提升达 3.44 倍。

*自研打关模型推理性能测试数据

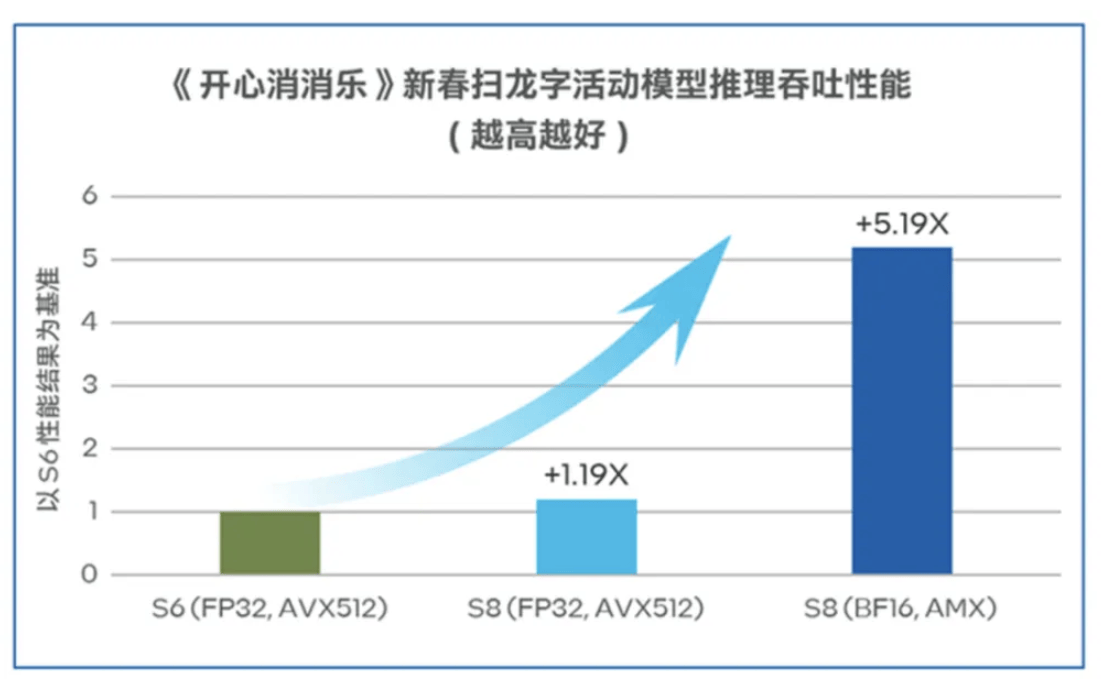

乐元素还在《开心消消乐》中引入了新春扫龙字活动,在玩家上传扫描的图片后,乐元素会通过图像分类识别领域常用的 ResNet-50 模型进行图片识别并返回结果。该模型在第五代至强® 可扩展处理器上的测试结果表明,启用了英特尔® AMX 后推理性能提升高达 5.19 倍。

*《开心消消乐》新春扫龙字活动模型测试数据

除了硬件加持以外,英特尔® oneDNN 还提供了深度学习构建块的高度优化实现,深度学习应用程序和框架开发人员可以对 CPU、GPU 或两者使用相同的 API,从而抽象出指令集和其他复杂的性能优化,大大降低编程人员优化 AI 推理性能的难度。

从以上实践案例不难看出,启用基于第五代英特尔® 至强® 可扩展处理器的新一代腾讯云实例 S8 后,开发厂商能游刃有余地应对自动打关等模型的推理需求,提升游戏开发和运营效率。开发厂商也很容易实现模型扩展,在更多环节引入 AI 技术,满足更多场景的需求。

通过部署第五代英特尔® 至强® 可扩展处理器的腾讯云实例,乐元素无需采用昂贵的专用 AI 服务器,还可以快速根据市场需求进行扩展,使企业在保持轻资产、轻运营压力的同时获得更高的投资回报率。

对于乐元素这样缺少大规模自建 AI 集群的企业而言,基于第五代至强® 可扩展处理器的腾讯云实例,让他们能够快速享受 AI 技术创新带来的价值,进而为广大终端用户带来更满意的产品和服务体验。

第五代英特尔® 至强® 可扩展处理器,为游戏行业 AI 创新注入持续动能

如今,AI 技术已经成为游戏产业发展的热门技术方向。一份研究报告预计,2024 年 AI 技术应用将为游戏公司带来约 21% 的人力成本下降。在此背景下,构建面向游戏开发与运营的 AI 算力平台,推动 AI + 游戏应用的创新,正在成为影响游戏公司竞争力的关键因素。

乐元素的实践证实,基于第五代英特尔® 至强® 可扩展处理器的腾讯云实例 S8 能够满足典型 AI 模型在推理算力上的需求,同时具备更高的经济性与灵活性,能够成为游戏企业拓展 AI 应用的理想选择。在当前合作成果的基础上,英特尔将与腾讯云和乐元素展开更多合作,加快步伐,将 AI 融入到游戏开发与运营的整体流程之中。英特尔与腾讯云的成果也将惠及更多游戏企业,持续为他们提供助力,满足轻资产、重人力类型的游戏厂商在激烈的竞争环境中降本增效的迫切需求。

芯片头条

-

投资8.5亿美元,全球首座金刚石晶圆厂明年量产

2024-12-18 -

中国移动推出北斗短信业务

2024-11-07 -

随着 AI 公司争夺高带宽存储芯片,美光的股价飙升

2024-09-26 -

富士康或斥资3720万美元 与HCL在印度设立OSAT公司

2024-09-13 -

供应链急单+AI需求,第二季全球前十大晶圆代工产值季增9.6%

2024-09-13